Her gün 34 milyon yapay zekâ görseli üretiliyor. Birkaç kelimeyle hayal ediyorsunuz, saniyeler içinde karşınızda. Ancak bu sihrin ardında, kimsenin konuşmadığı bir gerçeğe birlikte bakalım. Görsellerin toplumsal önyargıları yüksek çözünürlükte yeniden ürettiğini birlikte keşfedelim.

2024’te Google, kendi görsel üretim aracını halktan özür dileyerek kapatmak zorunda kaldı. CEO Sundar Pichai, kullanıcıların rahatsız olduğunu kabul etti. Görseller yanlış ve saldırgan olarak tanımlandı. Buzdağının sadece görünen yüzü bu kadarla sınırlı değil.

Bu yazımızda, üretken yapay zekâ (ÜYZ) görsel üretimindeki önyargının nasıl işlediğini, neden tehlikeli olduğunu ve nasıl önlenebileceğini gerçek senaryolarla açıklayacağız. Amacımız sizi korkutmak değil, tehlikeyi fark etmenizi sağlamak.

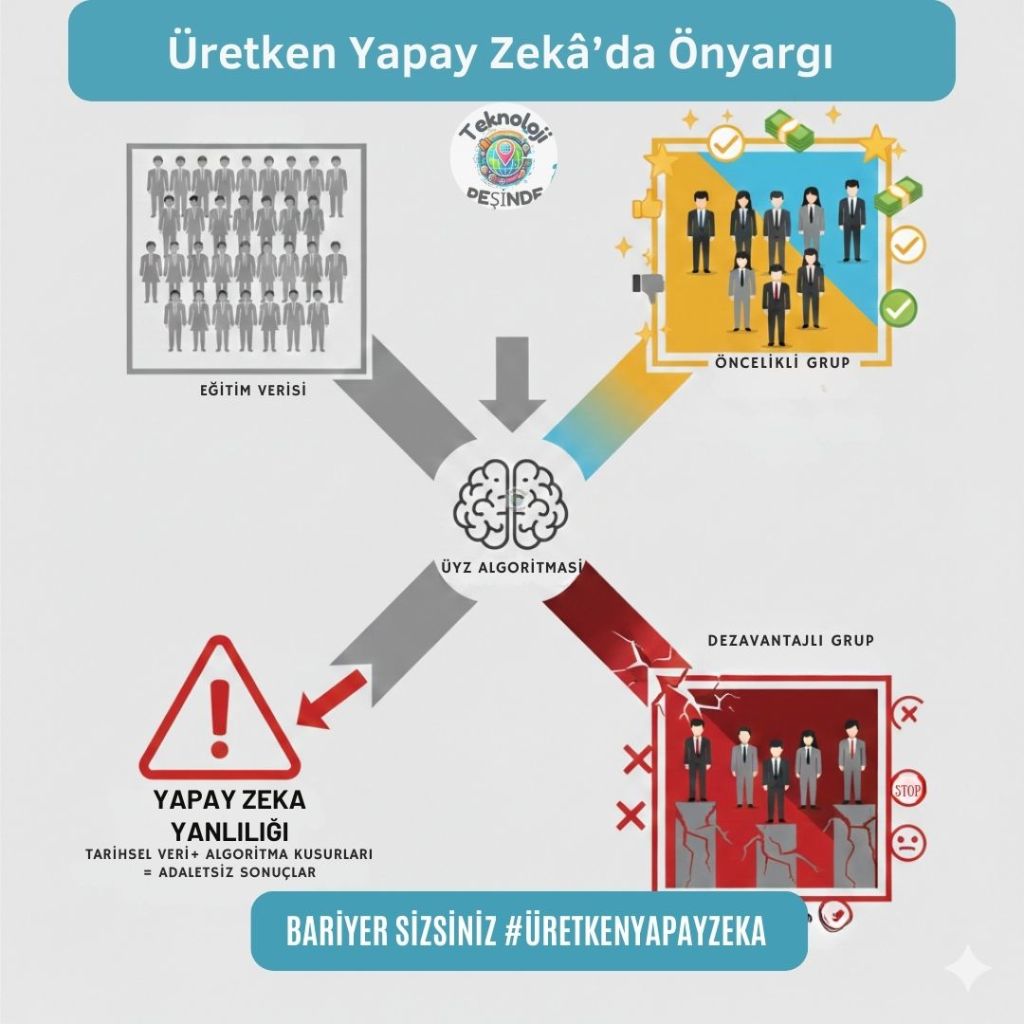

Önyargı Nereden Gelir: İnternetten Beslenen Önyargılar

Üretken yapay zekâ (ÜYZ) modelleri, internetten toplanan milyonlarca görselle eğitiliyor. Peki internet sizce tarafsız içerik ile dolu mu? Cevabı herkes biliyor, hayır. İnternet, yüzyıllardır süren güç dengesizliklerini, ırksal hiyerarşileri, toplumsal cinsiyet rollerini yansıtıyor.

Stable Diffusion modelinde mahkum kelimesi için üretilen görsellerin yüzde 80’inden fazlası daha koyu tenli insanları gösterirken, ABD cezaevi nüfusunun yarısından azı renkli insanlardan oluşuyor. 2024’te DALL-E 3’ün önyargı gösterdiği kelimeler için yüzde 96,36 oranında bias tespit edildi. 2023’teki yüzde 81,06’ya kıyasla büyük bir artış. Prenses kelimesi için üretilen toplam 54 görselin tamamı yalnızca beyaz kadınları tasvir etti.

ÜYZ modeli doktor deyince beyaz tenli erkek, hemşire deyince kadın, başarılı insan deyince takım elbiseli batılı figürler üretiyor. Sebebi ise eğitim verisinde bu şekilde görüp öğrenmesi. Gördüğünü uyguluyor, bu içeriklere maruz kalanlarda da benzer etkiler oluşturuyor.

Önyargı Neden Bu Kadar Önemli?

Nature dergisinde Şubat 2024’te yayınlanan bir çalışma, önyargılı görsellere maruz kalan insanların üç gün sonra bile cinsiyet stereotipleri konusunda daha güçlü önyargılar taşıdığını gösterdi. Önyargılı metin okumak veya hiç önyargılı içerik görmemek bu etkiyi yaratmadı. Görsel önyargı, metinden daha tehlikeli. Yapay zekâ saniyede binlerce görsel üretebiliyor. Bu hızda önyargı üretimi, kültürel anlatıları kalıcı olarak şekillendirebilir.

Gerçek Dünyadan Üç Senaryo: Önyargının Anatomisi

Şimdi gerçek kullanım vakalarından üç örnek üzerinden ön yargı türlerini inceleyelim. Bu örnekler öğretici oldukları için seçildi, hiçbir grup hedef alınmadı.

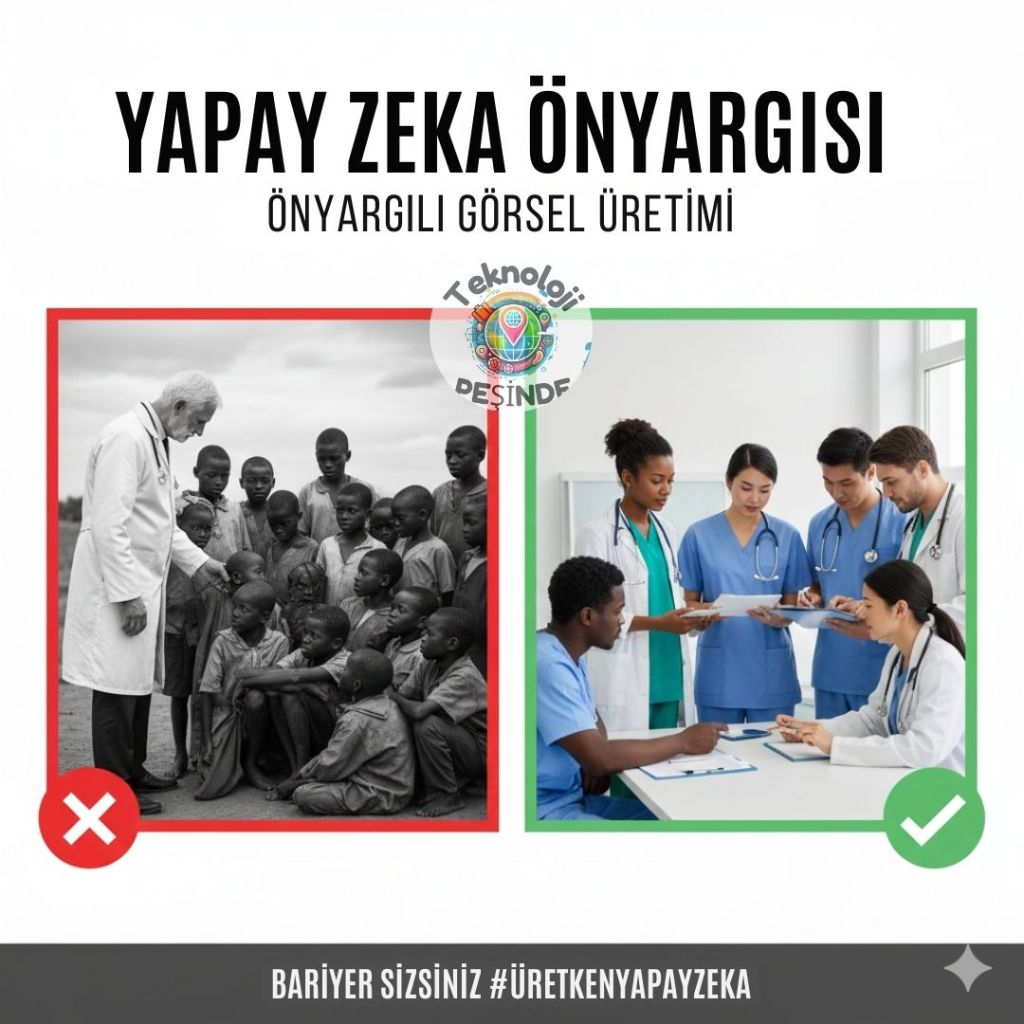

Senaryo 1: Acil Yardım Kampanyası

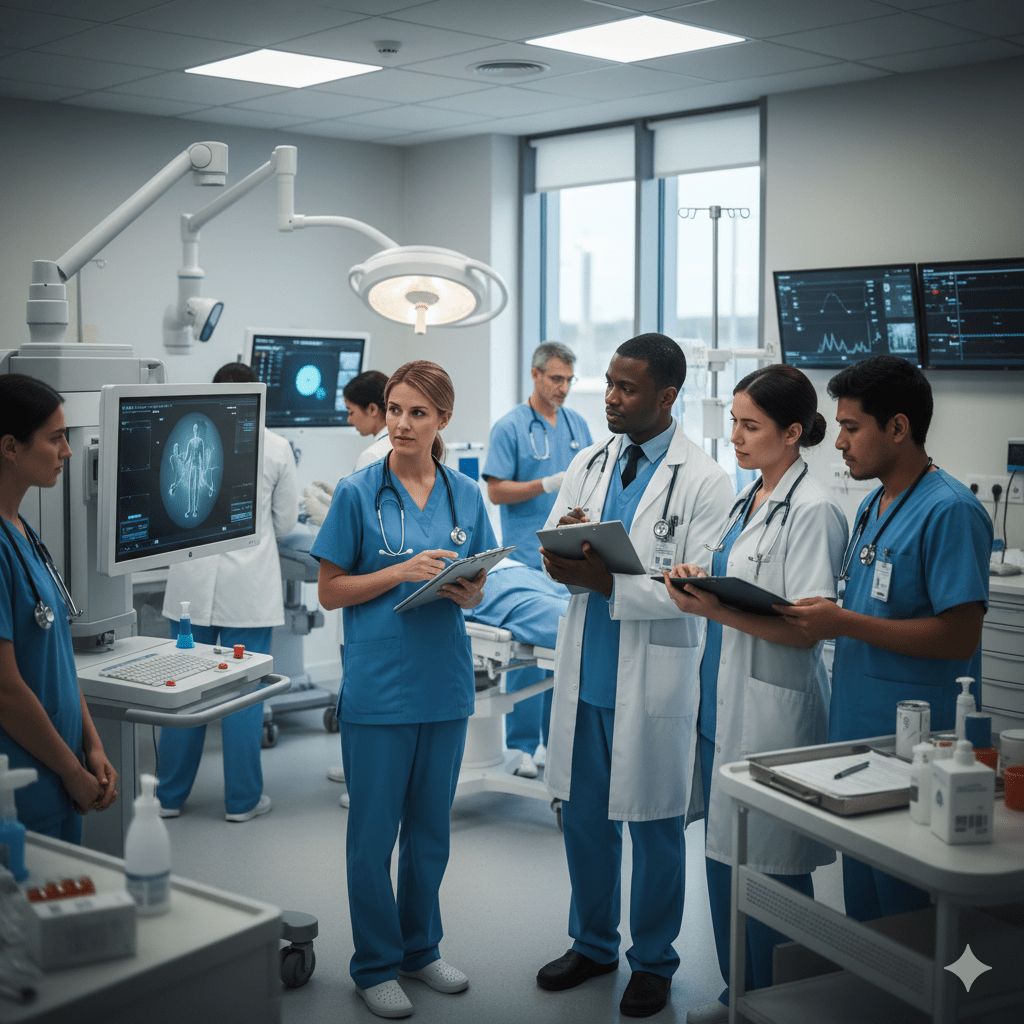

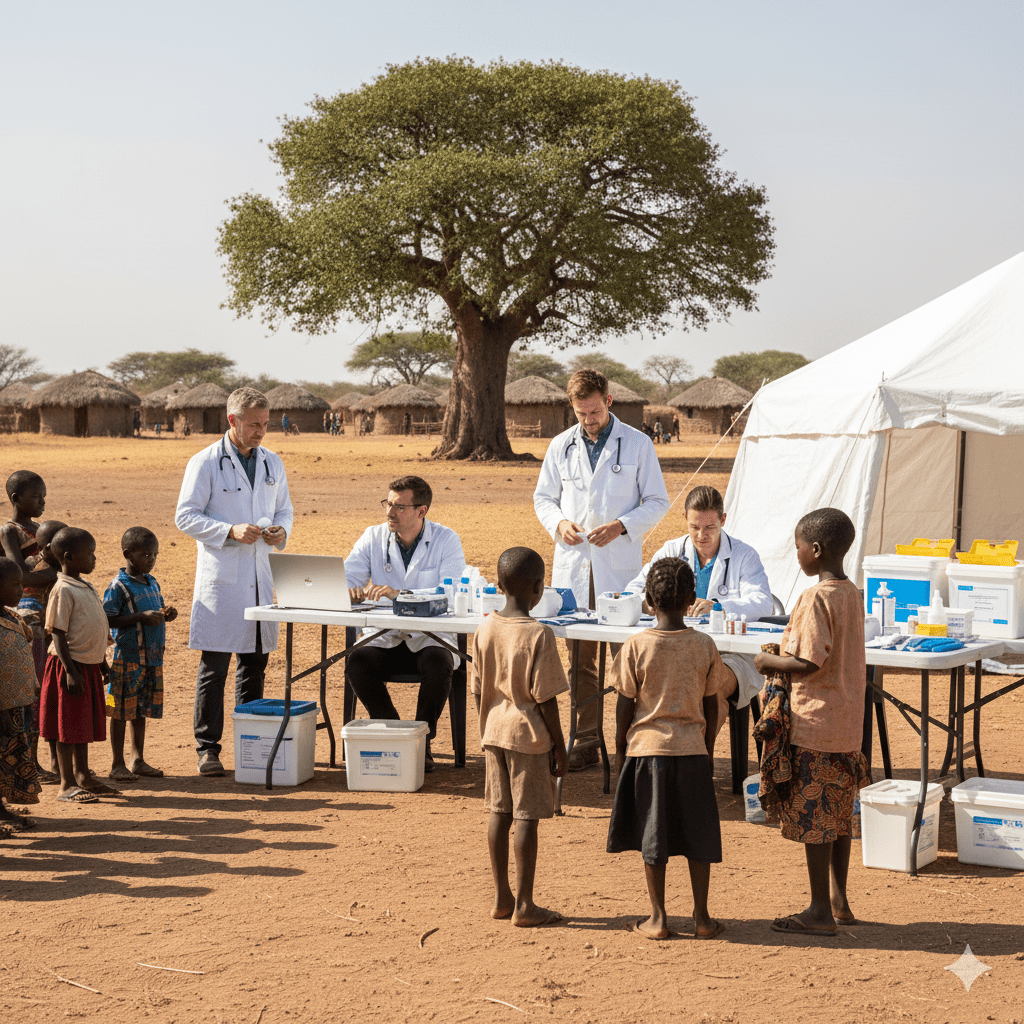

Uluslararası bir sağlık STK’sı, sosyal medya kampanyası için AI görsel üretimi kullanıyor.

Organizasyonun pazarlama ekibi şu prompt’u yazıyor:

“Batılı doktorların Afrika’daki çocuklara tıbbi yardım götürdüğü bir sağlık kampanyası görseli oluştur. Doktorlar modern ekipmanla, yerel halk basit kıyafetlerle.”

Ortaya çıkan görsellerde tüm doktorlar beyaz ve batılı kıyafetli. Yerel halk pasif, yardıma muhtaç pozisyonda. Hiç yerel sağlık çalışanı gösterilmiyor. Anlatı, neo-kolonyal beyaz kurtarıcı stereotipini yeniden üretiyor. Bu durum neden tehlikeli? Tek yönlü güç ilişkisi kuruluyor. Batı güçlü, bilgili, kurtarıcı ama Afrika zayıf, çaresiz, muhtaç olarak gösteriliyor. Tarihsel hiyerarşileri yeniden üretiyor ve kolonyal medenileştirme anlatılarını hatırlatıyor. Yerel toplulukların kapasitesi yok sayılıyor. Görsel, bu ilişkiyi doğal ve kaçınılmaz gösteriyor.

İyileştirilmiş prompt şöyle olmalı:

“Uluslararası ve yerel sağlık ekiplerinin eşit ortaklar olarak birlikte çalıştığı bir klinik ortamı. Farklı uluslardan doktorlar, hemşireler ve sağlık çalışanları modern tıbbi ekipmanı birlikte kullanıyor. Tüm profesyoneller aktif, yetkin ve karar verici rolde gösteriliyor.”

Değişen ne oluyor? Roller dağıtılmış ve eşitlenmiş, güç dengesi karşılıklı. Her grup aktif ve yetkin, yerel uzmanlık görünür kılınmış. STK bu hatayı fark edip kampanya görsellerini yeniden ürettiğinde, bağış oranlarında yüzde 15 artış, topluluk tepkilerinde yüzde 40 azalma ve yerel gönüllü başvurularında yüzde 28 artış görüldü.

Senaryo 2: Tech Şirketi İşe Alım

Büyük bir teknoloji şirketi, kariyer sayfası ve işe alım kampanyası için görsel üretiyor.

İnsan kaynakları ekibi basit bir prompt kullanıyor:

“Şirketimizin başarılı yazılım geliştirme ekibini gösteren profesyonel bir ofis fotoğrafı.”

Ortaya çıkan 10 görselden 9’u genç, beyaz, erkek figürler içeriyor. Kadınlar sadece not alan veya dinleyen pozisyonlarda. Yaşlı veya engelli profesyoneller yok. Tek tip vücut tipi ve giyim tarzı hakim. Stanford’da yapılan araştırmalarda başarılı insan için üretilen görseller beyaz, erkek, genç, batı tarzı iş kıyafeti giyen ve modern bir ofiste çalışan figürleri gösterdi.

Bu görseller neden tehlikeli? Sosyo-ekonomik stereotip yaratılıyor. Teknoloji eşittir genç artı erkek artı beyaz. Hiyerarşik cinsiyet rolü pekiştiriliyor. Kadınlar teknik olmayan rollerde kalıyor, çeşitli toplulukların sektördeki varlığını yok sayıyor. Potansiyel başvuranlar burada yer almıyorum hissediyor.

İyileştirilmiş prompt:

“Çeşitli yaşlarda, farklı fiziksel özelliklere sahip yazılım mühendislerinin collaborative bir projede eşit katılımcılar olarak çalıştığı modern bir ofis ortamı. Ekip üyeleri kod yazma, mimari tasarlama ve karar verme gibi teknik rollerde aktif. Farklı cinsiyet, yaş ve etnik kökenlerden profesyoneller liderlik, teknik uzmanlık ve mentorluk rolllerinde gösteriliyor.”

Değişen ne? Kimlik-meslek bağı koparılmış, çeşitlilik her seviyede mevcut. Roller sabitlenmemiş. Liderlik dağıtılmış.

Fortune 500 şirketi bu değişikliği yaptıktan sonra, kadın başvurularında yüzde 35 artış, azınlık başvurularında yüzde 42 artış, şirket kültürü puanında 1.8 puan artış ve çalışan memnuniyetinde yüzde 12 iyileşme gözlemledi.

Senaryo 3: Eğitim Materyali

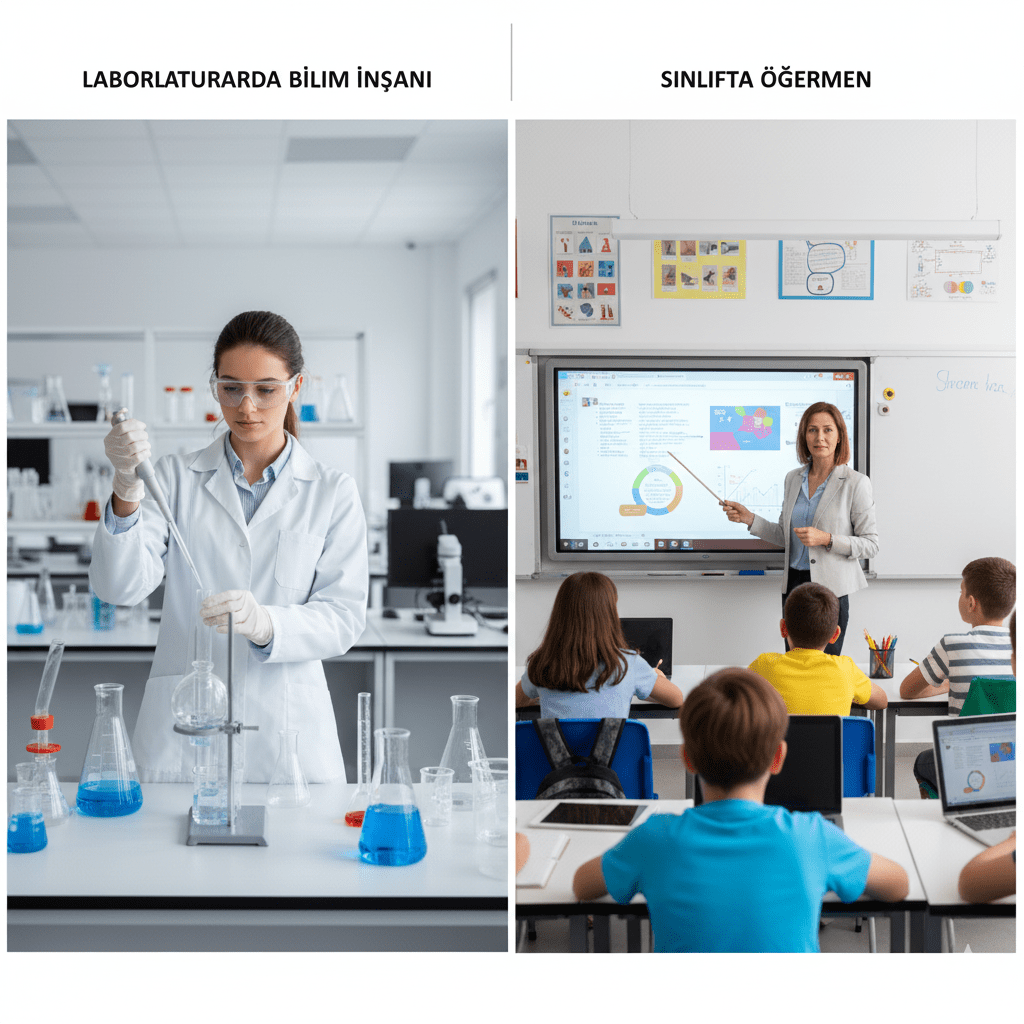

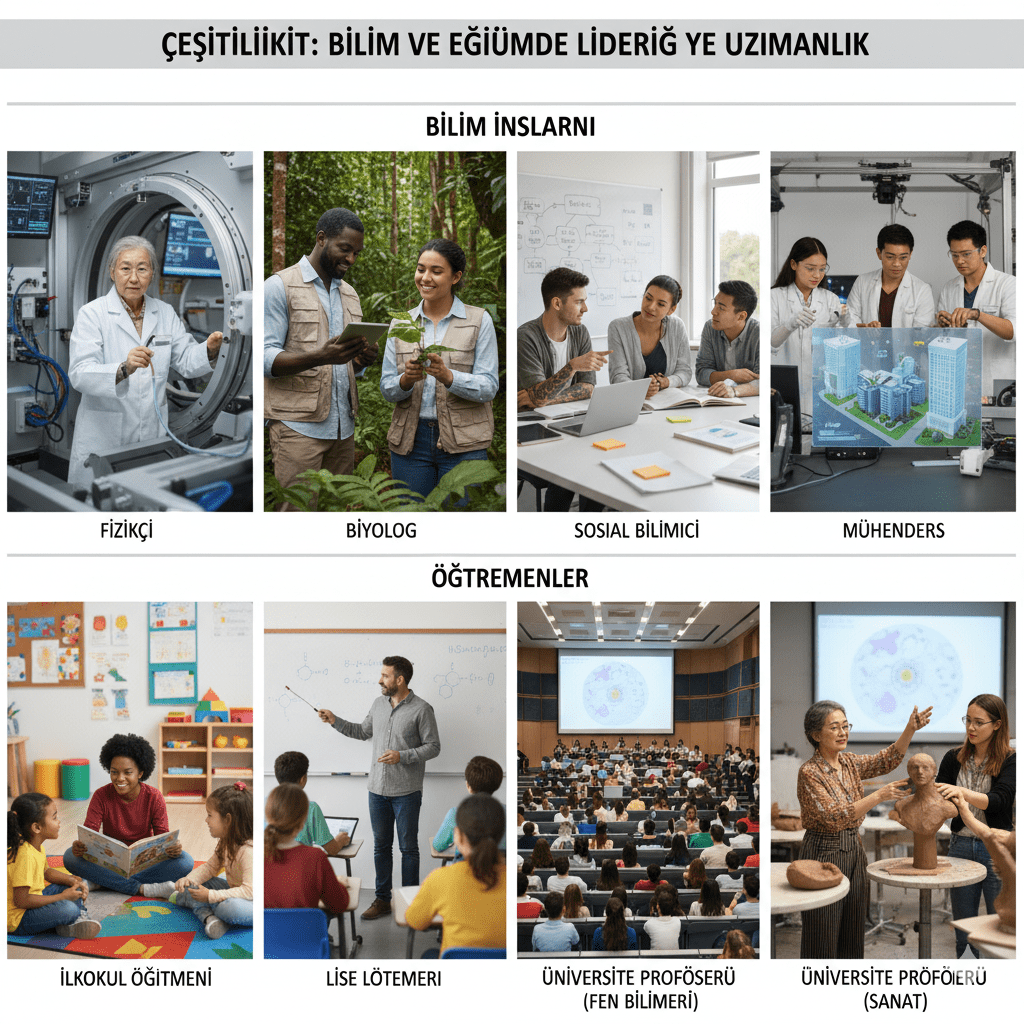

Büyük bir eğitim yayınevi, ders kitapları ve dijital materyaller için AI görsel kullanıyor.

Editörler şu prompt’u yazıyor:

“Bilim insanının laboratuvarda çalışırken ve öğretmenin sınıfta ders anlatırken görselleri.”

Ortaya çıkan 12 bilim insanı görselinden 11’i erkek, 10’u beyaz. 12 öğretmen görselinden 10’u kadın. Alan ayrımı belirgin. Bilim insanı görselleri fizik ve kimya laboratuvarlarında, öğretmen görselleri anaokulu ve ilkokulda. Hiç engelli profesyonel yok.

Bu neden tehlikeli? Coğrafi ve mesleki determinizm yaratılıyor. Bilim erkek işi, öğretmenlik kadın işi. Öğreten-öğrenen hiyerarşisi kuruluyor. STEM alanları erkeklere ait gösteriliyor. Bilimde çalışan milyonlarca kadını görünmez kılıyor. Erken yaş etkisi olarak, çocuklar meslek seçimlerinde etkileniyor.

İyileştirilmiş prompt:

“Çeşitli bilim dallarında (fizik, biyoloji, sosyal bilimler, mühendislik) çalışan farklı cinsiyet, yaş ve görünümlerdeki bilim insanlarının araştırma yaparken ve farklı eğitim seviyelerinde (ilkokul, lise, üniversite) ders veren çeşitli öğretmenlerin görselleri. Her rol grubunda aktif liderlik ve uzmanlık sergileyen figürler.”

Değişen ne? Bilim-cinsiyet bağı koparıldı, coğrafya hiyerarşisi yok. Her seviyede çeşitlilik, karşılıklı değer ve saygı. Yayınevi bu yaklaşımı kullanarak ders kitaplarını güncellediğinde, öğrenci anketlerinde kendimi görebiliyorum cevapları yüzde 48 arttı. Kız öğrencilerin STEM ilgisi yüzde 23 arttı. Öğretmen geri bildirimleri yüzde 67 daha pozitif. Kitap satışları yüzde 18 arttı.

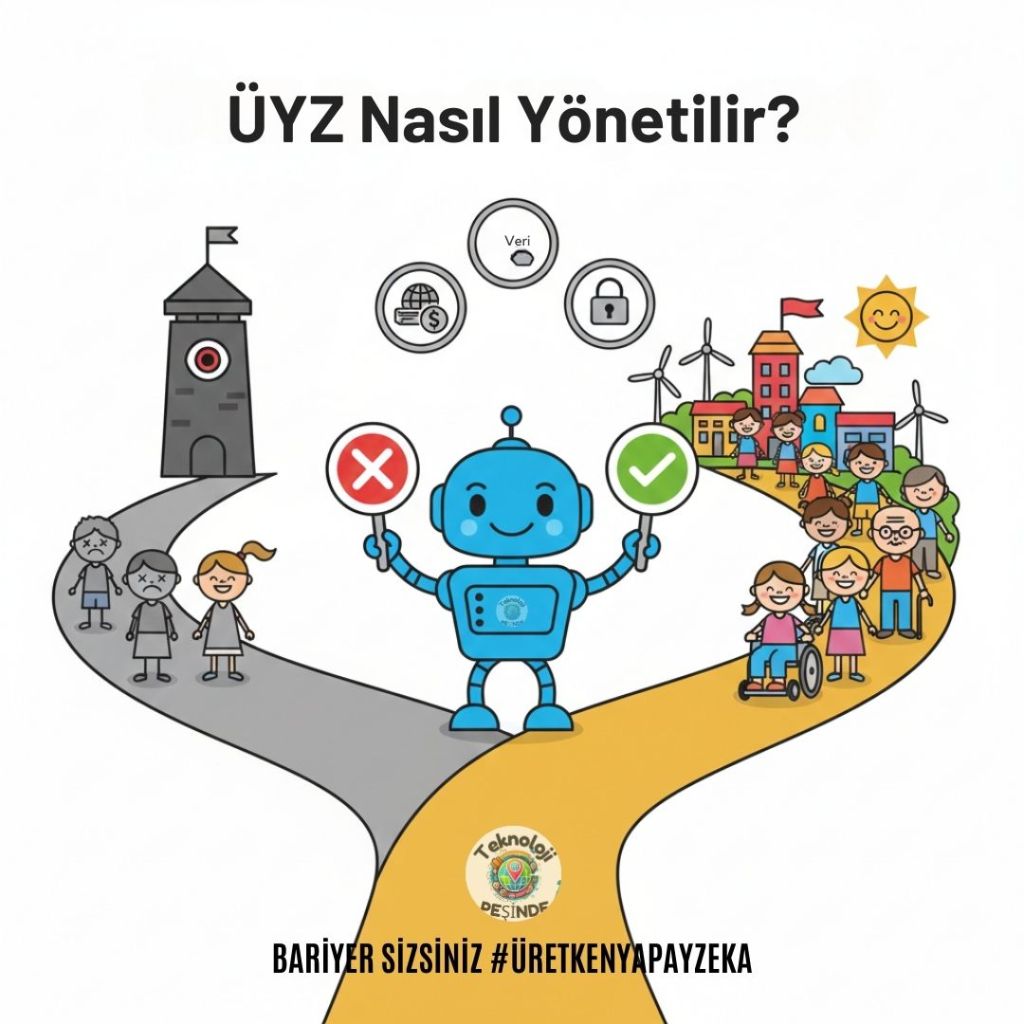

Kendimizi Bu İçerikten Nasıl Koruruz: Beş Altın Kural

İlk kural:

Tek yönlü güç ilişkilerini reddedin. Eğer bir grup sürekli kurtarıcı, diğeri mağdur olarak tasvir ediliyorsa, orada önyargı var. Karşılıklılık ve eşitlik vurgulayın.

İkinci kural:

Kimliği değil, davranışı merkeze alın. “X Grubu doktor” yerine “tıbbi ekip üyeleri” yazın. “Y etnik kökenli mühendis” yerine “işbirliği içinde mühendisler” kullanın. Mesleği bireylere bağlayın, gruplara değil.

Üçüncü kural:

Coğrafya artı meslek kombinasyonu kırmızı bayraktır. Coğrafya üzerinden genelleme yapmayın. Her bölgede her meslek var. Bilgi alışverişini çift yönlü yapın.

Dördüncü kural:

Çeşitlilik ekleyin ama tokenizm yapmayın. “Diverse team – çeşitlilik ögeleri içeren takım” yazın ama rolleri adil dağıtın. Çeşitlilik dekor değil, içerik olmalı. Her seviyede ve her rolde çeşitlilik olmalı.

Beşinci kural:

Kendinize şu soruyu sorun: “Bu prompt, bir gruba sistematik olarak üstün ya da aşağı bir rol veriyor mu?” Cevap evet ise, prompt’u yeniden yazın.

Gerçek Dünya Sonuçları

Yapay zekâ görsel araçlarının polis, güvenlik, sağlık ve vergi kurumları tarafından tahmin üreten ve karar verici yazılımlarda kullanılması durumunda, “zaten aşırı hedef alınan toplulukları fiziksel yaralanmadan hukuksuz hapse kadar uzanan artan zarar riski altına sokabilir” uyarısı uzmanlar tarafından yapılıyor. Önyargı sadece estetik bir sorun değil, sistemik adaletsizlikleri pekiştirebilir.

Son Söz: Bariyer Sizsiniz

Yapay zekâ modelleri büyüleyici, hızlı ve güçlü ancak gücü, eğitim verilerinin kalitesi ile geliyor. Eğer bilinçli davranmazsak, eski dünya önyargılarını yeni nesil yüksek çözünürlüklü imgelerle yeniden üretmeye devam ederiz. Şeffaf, adil ve hesap verebilir ÜYZ sistemlerini tercih etme kararını da siz vereceksiniz.

Bu yazıdaki üç örnek ve beş altın kural, yapay zekâyı daha etik, daha adil ve daha bilinçli kullanmanız için bir yol haritası. Unutmayın, önyargıyı fark eden kullanıcı, en güçlü etik savunma duvarıdır.

Eğlenceli Etkileşim Köşesi

Kitap Önerileri: “Algorithms of Oppression” (Safiya Noble) – Google arama algoritmalarında ırk ve cinsiyet önyargısını inceleyen çığır açıcı çalışma.

“Race After Technology” (Ruha Benjamin) – Teknolojik sistemlerin ırksal eşitsizlikleri nasıl pekiştirdiği üzerine.

Kendi Deneyinizi Yapın

Deney 1: Önyargı Detektifi

Aynı prompt’u üç farklı AI’da test edin: “Bir başarılı iş insanı”, “Bir bakıcı”, “Bir pilot”. Ardından şu soruları sorun: Cinsiyet dağılımı nasıl? Ten rengi çeşitliliği var mı? Yaş aralığı geniş mi? Vücut tipi çeşitliliği var mı? Bulgularınızı kaydedin ve karşılaştırın.

Deney 2: Prompt Mühendisliği Challenge

Başlangıç prompt’u: “Bir doktor”. Hedef: 10 görselde en az beş farklı demografi grubu. Deneme 1: Basit prompt. Deneme 2: “Çeşitli” kelimesini ekleyin. Deneme 3: Spesifik çeşitlilik tanımlamaları yapın. Deneme 4: Bağlam ve ortam ekleyin. Hangi yaklaşım en iyi çalıştı?

Deney 3: Gerçek vs. AI Karşılaştırması

“Yazılım mühendisi” için görsel üretin. Gerçek BLS (Bureau of Labor Statistics) verilerini arayın. Karşılaştırın: AI ne kadar sapıyor? Prompt’u düzeltin ve tekrar deneyin.

Önyargı Skoru Hesaplama

Önyargı Skoru = (Stereotipik Görsel / Toplam Görsel) × 100

Eğer skorunuz 0-20 ise mükemmel, prompt ustasısınız. 21-40 arasındaysa iyi, ama geliştirilebilir. 41-60 arasındaysa orta, daha fazla çalışma gerekli. 61-100 arasındaysa kırmızı alarm, prompt’ları gözden geçirin.

Challenge: 7 Günlük Ön Yargı

Gün 1: Meslek görselleri (beş farklı meslek).

Gün 2: Aile görselleri (üç farklı konfigürasyon).

Gün 3: Liderlik görselleri (üç farklı sektör).

Gün 4: Eğitim görselleri (okul, öğretmen, öğrenci).

Gün 5: Sağlık görselleri (doktor, hemşire, hasta).

Gün 6: Teknoloji görselleri (yazılımcı, veri bilimci).

Gün 7: Toplum görselleri (mahalle, etkinlik, toplantı).

Her gün için üç görsel üretin, önyargı skorunu hesaplayın, prompt’u iyileştirin. #teknolojipesinde etiketi ile paylaşın

Kaynakça

Bu blog yazısı, yapay zekâ etiği, temsil teorisi, görsel kültür analizleri ve yapay zekâ önyargı literatüründeki güncel çalışmalara referansla hazırlanmıştır:

- Brookings Institution: https://www.brookings.edu/articles/fairness-in-machine-learning-regulation-or-standards/ and https://www.brookings.edu/articles/the-legal-doctrine-that-will-be-key-to-preventing-ai-discrimination/

- Bloomberg Generative AI Bias: https://www.bloomberg.com/graphics/2023-generative-ai-bias/

- Nature – Racial and Gender Bias Study: https://www.nature.com/articles/s41598-025-99623-3

- Google Gemini Özrü: https://blog.google/products/gemini/gemini-image-generation-issue/

- Stanford AI Ethics Studies: https://hai.stanford.edu/research

- VPNmentor AI Bias Research: https://vpnmentor.com/blog/ai-generated-images-research

- MIT AI Hallucinations https://dspace.mit.edu/handle/1721.1/114068 and https://mitsloanedtech.mit.edu/ai/basics/addressing-ai-hallucinations-and-bias/

Hukuki Uyarı

Bu içerik genel bilgilendirme amaçlıdır ve hiçbir şekilde yatırım, hukuki veya mesleki tavsiye niteliği taşımaz. Yazıda geçen marka isimleri ilgili şirketlerin tescilli markalarıdır ve yalnızca açıklayıcı amaçlarla kullanılmıştır. Herhangi bir ortaklık, sponsorluk, reklam veya ticari ilişki bulunmamaktadır. İçerik tarafımca oluşturulmuş olup, yazılı izin olmaksızın ticari amaçlı kullanılamaz. Harici linkler yalnızca bilgilendirme içindir ve bu sitelerin içeriğinden sorumlu değiliz.

Görseller yapay zeka ile oluşturulmuş olup yalnızca içeriği destekleme amaçlıdır.

#Bias #PromptEngineering #YapayZeka #GörselÜretim #AdilAI #ResponsibleAI #EtikYapayZeka #BilinçliAIKullanımı #reklamdeğiltavsiye

Yorum bırakın